文凯认为,大规模神经网络是AI未来发展趋势,而量子计算“必能破局”,因为量子计算具有算力、存储、带宽、容错四大方面的优越性。

本文来自: 谢矩题图来自“外部授权”

9月27日,2021年中国国际信息通信展览会(PT展)在北京正式开幕。PT展由工业和信息化部主办,是泛ICT行业最具行业影响力的展会之一。

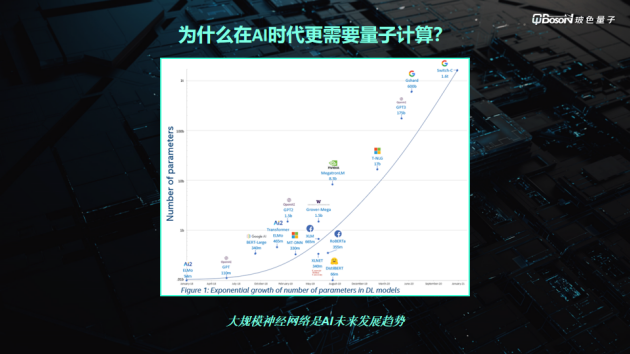

在开幕当日举办的量子计算专题论坛上,玻色量子创始人&CEO文凯发表了以《走向AI时代的量子计算》为主题的演讲。他在演讲中表示:“自从深度学习被提出以来,深度学习参数的高速提升和大规模神经网络等都是AI快速发展的直接表现。量子计算可以解决AI快速发展所带来的算力、带宽、存储空间等不够的问题,同样的人工智能也可以为量子计算解决容错率低的问题。”

文凯将量子计算的发展分为四大阶段:

第一阶段为1981~1993年,是理论提出及探索阶段,主要物理学家有保罗·贝尼奥夫、理查德·费曼、大卫·德依奇(Deutsch算法提出者)。

第二阶段为1994~2009年,是通用量子算法发展阶段,主要物理学家有shor算法提出者彼特·肖尔、Grover算法提出者罗夫·格罗弗和HHL算法提出者阿兰·哈罗、阿维那坦·哈西迪、赛思·罗伊德,物理学家们就开始了不同物理体系单比特和两比特量子计算实验验证。

第三阶段为2010~2017年,是近期量子算法繁荣阶段,以谷歌、IBM为代表的企业开始进行规模化量子计算机实验工程化。

第四阶段为2018年至今,是量子AI爆发阶段。

量子计算目前处于技术研究、样机研发与应用探索的关键阶段,在学术界和产业界多方推动下获得迅速发展。2020年12月,我国科学家成功构建76个光子的量子计算原型机“九章”,再次实验验证“量子优越性”。

在IBM、Honeywell和lonQ等公司的推动下,超导和离子阱等技术路线样机的量子体积指标进一步提升。在化学、金融、交通等领域,量子计算的潜在应用探索加速。量子计算受到社会舆论和资本市场的持续关注,对技术和产业形成良性激励,量子计算进入技术攻坚与应用探索的“黄金时期”。

在此背景下,国内外诸多科技企业和初创企业纷纷布局,包括IBM、Google、Amazon、Microsoft、D-wave、lonQ、Reggeti、华为、阿里、百度、腾讯、本源、量旋、启科等,纷纷发布和推出量子计算处理器和原型机、量子计算软件和开发工具,以及量子云计算服务等。量子计算的应用探索、产业培育和生态构建正逐步展开。

文凯认为,大规模神经网络是AI未来发展趋势,而量子计算“必能破局”,因为量子计算具有算力、存储、带宽、容错四大方面的优越性:

1、算力优越性:量子的叠加态,使得量子计算具有对求解问题的指数级并行算力加速。

2、存储优越性:量子神经网络的容量可以远超于经典神经网络,用指数级量子存储模型,可以用1200个量子比特存储GPT3的整个网络模型。在一定的算法下,数据也可以用量子模型存储,节省存储空间。

3、带宽优越性:在国家东数西算大背景下,带宽成为算力瓶颈,这些瓶颈不仅来自神经网络,还有内存和缓存的带宽。量子计算数据和模型的存储压缩,可以指数级优化带宽。

4、容错优越性:中短期之内,在纠错还没有做到100%精准的情况下,可以利用量子神经网络的鲁棒性和容错性来实现对冲。

文凯将当前面向神经网络的量子计算架构分为三种:IBM和谷歌正在研发的门电路通用量子计算、D-Wave的量子退火计算,以及玻色量子自主研发的相干量子计算。”

前两者在共同点上都需要真空超低温稀释制冷机的环境控制,体积较为庞大。在文凯看来,玻色量子自主研发的光量子技术路线,通过对激光的精准控制,不需要超低温超导环境,在室温下即可运行,具有稳定的状态,稳定的操控,和稳定的结果“三稳”优势。

同时,文凯表示,玻色量子的“相干量子计算方案”是已实现的比特数规模最大的技术方案,也是主流方案中有望最快实现百万量子比特规模的方案之一。在商业化应用场景上,能在成本、功耗可控的条件下,即刻解决当下许多需要使用超大算力加速的问题。

以下为文凯的演讲全文:

(玻色量子创始人、CEO文凯/来源:2021中国国际信息通信展览会)

大家好,我是北京玻色量子科技有限公司的创始人、CEO文凯。我今天给大家分享量子计算走向AI时代的历程,给大家简单介绍一下量子计算的发展史,同时再介绍跟人工智能的关联。

说到量子计算,现在大家都觉得是一个非常前沿的技术。实际上,这个技术已经发展了有40年。这个技术的开端就是从1981年的夏天在MIT举行的第一届面向计算的物理学大会上开始。

这届大会上出现了两位从事量子计算的宗师,一位是大家比较熟悉的理查德·费曼,另外一位是保罗·贝尼奥夫,他们两个人在这个会议上首次提出了量子计算机的概念。从那天开始,量子计算机就正式走入我们历史的进程,所以才有我这样的一个机会,站在这里跟大家讲述。

根据我自己多年的科研经验,我觉得,在量子计算这40年的发展历程中分成四个阶段。

首先在第一个10年里面,理查德·费曼和保罗·贝尼奥夫他们提出了量子计算机的概念,另外一个著名的学者叫David Deutsch提出了第一个量子计算算法。这第一个10年里,量子计算还是停留在理论的提出和探索阶段。

历史的车轮来到1994年。那一年,MIT的Peter Shor提出了大家熟知的Shor质因数分解算法。这是第一次在实际问题里面,展现了量子计算指数加速的效果。

从此,就开启了通用量子算法发展的新阶段。在这个阶段里面我们有三个代表性的算法:一个是Shor算法;另外一个是Grover算法,清华的龙桂鲁教授也在这方面做了一些贡献;第三个就是线性方程组求解加速算法,我们简称HHL,是由MIT的三位学者提出的。

在这个阶段里,由于算法加速的优势,实验物理学家也开始进行单量子比特和两量子比特的物理体系的量子计算实验验证。

2010年开始,以谷歌和IBM为代表的企业开始进行规模化的量子计算实验和工程化。这时候,大家发现,即使在含噪声的中等规模的量子计算体系(NISQ)里面,又发现一些算法可以体现量子的优越性。它们就是玻色采样、VQE(变分量子本征求解器)以及QAOA(量子近似优化算法)。

2018年至今,我觉得这是一个量子计算全新的令人振奋的阶段——量子和人工智能相结合的爆发的阶段。

提到这个阶段,我们就不能不提像谷歌发布的TensorFlow Quantum这样的架构。TensorFlow是谷歌提出在业内广泛使用的深度学习的框架,它主动把TensorFlow和量子计算相结合。

这里面有一个非常著名的例子:在2018年,由谷歌研究员提出用量子门电路的一些参数以及量子测量打造的一个量子计算的神经层,跟经典计算的神经层相结合,通过梯度下降的优化,实现深度学习识别的算法,在小规模训练中已经取得了不亚于经典神经网络的计算的结果。

随之而来的是,更多量子与AI结合的结果出现,包括QCNN(量子卷积神经网络)、QNLP(量子自然语言处理),QGM(量子生成模型)等成果。

为什么我是觉得在AI时代更需要量子计算?

大家可以从这张图看:深度学习自从提出以来,参数的规模是呈一个指数增长的状态,右上角有一个大规模自然语音处理的训练模型GPT-3,它本身有接近1750亿个参数。这样的大规模神经网络是AI未来发展的趋势。但它本身也带来了巨大的算力、存储、带宽等问题。

(AI时代参数规模呈指数增长/来源:玻色量子)

为解决这些问题,大家除了建造更大的数据中心,买更多的GPU显卡以外,还在探索不同计算的路径。我认为,量子计算所带来的指数加速效果,实际上是一个很好解决大规模神经网络运算的解决方案。

这里面我可以提出来新的指标。谷歌在2019年发表的论文已经解决了证明量子计算的优越性的问题。它通过50多个量子比特能够替代超级计算机,在解决特定问题时要比经典超级计算机快非常非常多。

我们刚才提到的GPT-3模型,它里面有1745亿个参数,每个参数是32位的单精度浮点。这么大的一个模型,在经典超级计算机里面用一张显卡或者一台机器是无法承载的。而在量子存储器里面,利用用量子比特的叠加态,通过指数的叠加,其实只需要60个量子比特就可以完全承载这么大规模的参数。那其实就是量子在人工智能领域优越性的体现指标之一。

量子的优越性在人工智能里面分为以下几个方面:

首先是算力优越性。量子计算通过量子的叠加实现了指数级增长,从而使得在神经网络的训练和优化里可以得到指数级加速的效果。

第二个是存储的优越性。就像刚才提到的像GPT-3这样的模型,它的参数可以用60个量子比特可以进行存储,对于存储空间是大大的优化。另外训练数据不光是模型非常大,人类每天还会产生上百个PB以上的数据,这么大规模的数据如果能通过量子存储器进行指数压缩的存储,那可以大大减少它们存储的空间。

第三个是带宽优越性。国家提出了“东数西算”的战略,就是东部产生、存储的数据,由西部进行运算。这会给东部和西部之间的数据传输的带宽带来巨大的挑战。如果每天都要传输几百个PB以上的数据,整个网络带宽是会面临非常大的压力。

在人工智能的神经网络数据处理中,不光存在着数据中心之间的带宽,还有机器之间的网络带宽,甚至在机器内部还存在着内存、总线以及线上缓存带宽。这些都是一个未来潜在的瓶颈。因为摩尔定律CPU的算力在20年来已经有几个数量级的提升,而带宽经历20年只有接近30倍的提升。随着神经网络规模的不断扩大,网络对带宽的需求会逐渐变成一个很严重的瓶颈。

通过量子存储器可以用少数的量子比特就能存储大量数据,同时进行网络训练,这样的话就可以从根本上解决带宽的瓶颈。

第四个是在神经网络里面有一定的鲁棒性和容错性。这样带来量子计算的好处就是在纠错还没有完全达到百分之百精确的情况下,我们可以通过神经网络自身的一些鲁棒性,可以去对冲掉量子计算自身的一些容错需求。

最后我们也介绍一下在量子计算的三种不同实现的架构:

(面向神经网络的量子计算架构/来源:玻色量子)

首先就是IBM在做的,基于门电路的通用量子计算设备。大家可以看到这里面最左边图,这是一个体积巨大的系统,采用了超导量子比特路线,需要在真空超低温的环境下才能稳定运行。

中间这个图是量子退火机,以加拿大D-Wave公司为代表。他们也采用了超导量子比特方案,也需要真空和超低温,所以体积也非常大。在这些超导路线的设备里,需要超低温和真空,不参与计算的能耗非常大。

而第三个是我们公司现在自主研发的相干量子计算设备。它专门针对神经网络设计,是一种基于光量子物理实现的量子计算设备,在室温下就可以稳定运行,所以不需要额外的制冷能耗。相比于前两者,我们的方案在能耗应用比上就拥有了一个巨大的优势。

玻色量子的口号就是“用量子重新定义AI”,实现用量子计算给人工智能带来上述算力、存储、带宽、容错上的优势。我们欢迎各位海内外的专家、学者能够加入我们,一起来开创量子AI的新时代。

营业执照公示信息

营业执照公示信息